Celina Bialke

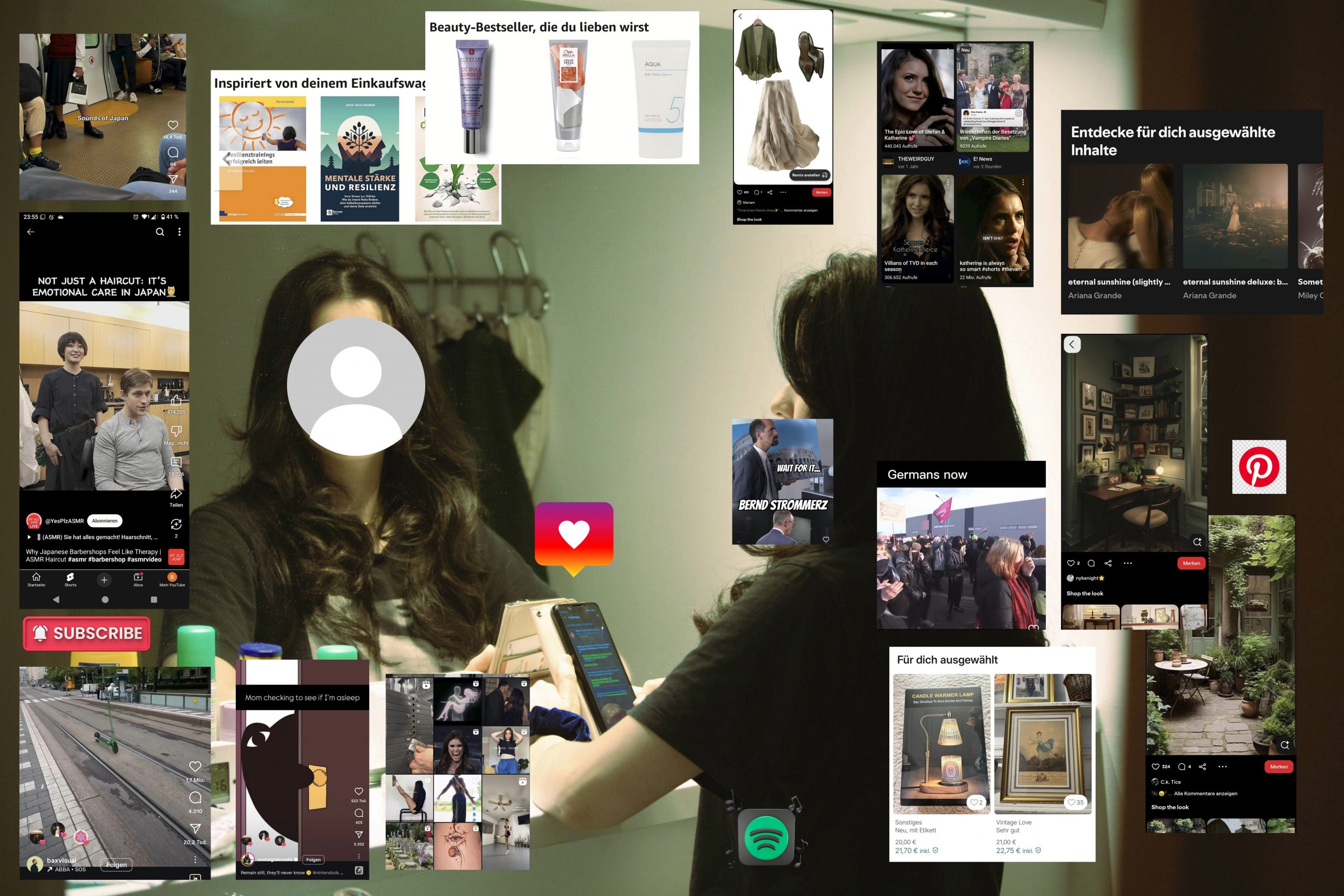

Algorithmen sind mittlerweile normal und haben sich leise in unseren Alltag eingeschlichen: auf Netflix, YouTube, Tiktok und Instagram, Amazon-Prime, ChatGPT, etc. Wir wissen bereits, dass der Algorithmus basierend auf unseren Interessen und unseren Persönlichkeitsmerkmalen passende Inhalte empfiehlt. Oft wirken daher personalisierte Feeds auf sozialen Medien wie ein „digitaler Spiegel“. Nun stellt sich die Frage, ob der Algorithmus wirklich nur unser Spiegel ist – oder längst zum Bildhauer geworden, der uns unmerklich verändert und formt.

Unsere Identität wird maßgeblich durch soziale Erfahrungen geformt und verändert. Was jedoch oftmals vergessen wird, ist die Tatsache, dass Medien Teil des identitätsbildenden Prozesses sind. Denn an erster Stelle sind Medien Gegenstände, mit denen sich Kommunikation bzw. Interaktion herstellen lässt (vgl. Mock, 2006, S.183).

Schon lange bevor soziale Medien ins Blickfeld rückten, wurde bei den klassischen Leitmedien darüber diskutiert, in welchem Maß sie menschliche Identität prägen und formen können. Zum Beispiel wurde dem Lesen von Fiktion nachgesagt, dass sie unsere Empathie fördern würden, indem es unsere „Theory of Mind“ schult – also die Fähigkeit, die mentalen Zustände und Gefühle anderer nachzuvollziehen, um eigenes oder fremdes Handeln zu erklären. In den 70er Jahren entstand sogar die Kultivationshypothese, dass Fernsehen eine Wahrnehmungsverzerrung verursachen würde und die Menschen ein Mean-World-Syndrom entwickeln könnten, d.h. sie würden alles gefährlicher und gewalttätiger wahrnehmen, als es tatsächlich der Fall ist. Was für einen Einfluss könnte also die Nutzung von algorithmus-basierten und personalisierten Medien, besonders im Kontext sozialer Medien, auf uns haben?

Algorithmen erstellen ein digitales Profil jedes Nutzers, eine algorithmic identity. Dabei werden Informationen über den Nutzer gesammelt, sodass die Daten verallgemeinert, kategorisiert und schließlich wieder auf die Person zurückprojiziert werden können. Der Algorithmus kann also über das Nutzerverhalten, wie zum Beispiel durch Watch-Times, Likes und Follow-Funktion, Werte und Interessen über die einzelne Person ableiten. Durch diese Hyperpersonalisierung von Inhalten werden individuelle Informationswelten geschaffen, die sich von Person zu Person unterscheiden. Diese Informationswelten können sich jedoch partiell überschneiden. Zum Beispiel können zwei komplett verschiedene Menschen aus komplett verschiedenen Ländern eine Sache gemeinsam haben: beide haben ADHS und sehen sich Selbsthilfe-Content auf Instagram an (vgl. Foster & Ellis, 2024). So entsteht eine besondere Form der sozialen Erfahrung, bei der keine direkte Interaktion mit anderen Menschen stattfindet, aber ein Gefühl der Zugehörigkeit entstehen kann.

Doch hinter dem Prinzip der Hyperpersonalisierung verstecken sich unsichtbare Gefahren. Zum einen gibt es aufgrund unterschiedlicher Informationsökosysteme, anders als bei traditionellen Medien, keinen gemeinsamen Referenzrahmen mehr für gesellschaftliche Diskussionen. NutzerInnen tendieren dazu, immer weiter Inhalte zu konsumieren, die mit ihren Interessen und Werten kongruent sind und gelangen in einen Kreislauf des Bestätigungsfehlers – oft wird dieses Phänomen auch als echo chamber oder rabbit hole bezeichnet (vgl. Brookings Institution, 2022). Dies birgt Gefahr für kognitive Verzerrungen und systematische Manipulation. Die Verbreitung und Verstärkung von Botschaften sind einfacher denn je: Die ursprüngliche Intention, mit dem Algorithmus das Nutzerengagement zu maximieren, kann für politische Zwecke instrumentalisiert werden – es wird künstliche Sichtbarkeit und Reichweite geschaffen, sodass ein bestimmtes Narrativ stärker in den Fokus rückt. Algorithmen, besonders im Kontext der sozialen Medien, erlauben also unterdrückende Machtverhältnisse aufrechtzuerhalten und formen so die Identität der NutzerInnen. Gesellschaftliche Vorurteile und feindselige Einstellungen werden durch Confirmation Bias verstärkt (vgl. Ludwig et al., 2025).

Zunehmend lässt sich eine „digitale Kluft“ beobachten zwischen denjenigen, die eine erhöhte algorithmic literacy (Algorithmenkompetenz) aufweisen und denjenigen, die die Funktionsweise und die Wirkung der Algorithmen wenig hinterfragen. Besonders geringe Medien- und Algorithmenkompetenz weisen bildungsferne Schichten auf. Dabei werden Entscheidungsprozesse dieser Gruppe durch die Algorithmen-Infrastruktur stark beeinflusst und hindert sie daran, informiert an staatlichen, zivilgesellschaftlichen und unternehmerischen Prozessen teilzunehmen.

Was kann man also tun, um den Einfluss der Algorithmen auf unsere persönliche Wahrnehmung und Einstellung zu verringern? Nun, mein Vorschlag wäre es die algorithmic literacy zu erhöhen. Dafür gibt es verschiedene Projekte, wie zum Beispiel der „Algorithmic Mirror“ (Kondo et al., 2025). Damit soll eine metakognitive Bewusstheit über das eigene Verhalten im digitalen Raum geschaffen werden. Die NutzerInnen realisieren dabei, dass ihre digitale Identität „fragmentiert“ ist, d.h. je nach Plattform sich unterscheidet. Außerdem können sie überprüfen, inwiefern das Konsumverhalten sich mit den eigenen Interessen und Zielen überschneidet oder auch nicht. Insgesamt kann man durch das „Algorithmic Mirror“ also kritische Reflexion anregen und einen kompetenten Umgang mit algorithmus-basierten Plattformen fördern.

Algorithmen sind nicht länger bloße Reflektoren unseres Selbst, sondern aktive Ko- Produzenten unserer Wirklichkeit. Sie filtern Erfahrungen, gewichten Beziehungen und verschieben Wertmaßstäbe – unmerklich und zugleich tiefgreifend. Daher darf sich Algorithmenkompetenz nicht mehr auf die Frage beschränken, was wir im Spiegel sehen wollen, sondern muss klären, wer den Spiegel hält und warum. Nur dann bleibt Identitätsbildung ein eigener, nicht ausgelagerter Prozess.